Sommes-nous si proches de l'intelligence artificielle forte ? (TedX)

Cet article est inspiré d’une conférence TedX@EMI (Rabat) de vulgarisation scientifique sur l’intelligence artificielle que j’ai donné le 20 décembre 2018. La vidéo de l’ensemble de la conférence est disponible sur Facebook (page TedX@EMI) ainsi que sur TED : https://www.ted.com/talks/issam_el_alaoui_sommes_nous_si_proches_de_l_intelligence_artificielle_puissante

L’article est volontairement vulgarisé et rendu concis, à l’image du speech de la conférence. Bonne lecture.

C’était il y a 20 ans, et j’étais un ado rêveur.

Les chaînes de dessins animés nous promettaient déjà dans les années 70 des voitures qui volent, des robots assistants multi-fonctions, des cités futuristes flottant dans le ciel. Les Jetsons ont été l’incarnation de cet avenir radieux qui faisait rêver les enfants. On ne se doutait alors pas de l’accélération technologique formidable qui allait arriver.

Isaac Asimov, le célèbre écrivain de science-fiction, lui, nous promettait dans les années 80 le multivac, cet ordinateur-gouvernement qui permettait à la société de se gérer parfaitement : élections, mariage, régulations économiques, justice. C’était le Big Brother bienveillant, empathique qui menait l’humanité vers le salut. On retrouve ce même Big Brother dans un grand nombre de nouvelles qui l’a écrit et dans lesquelles il prend souvent la forme d’un robot humanoïde caché (ou pas) parmi les humains.

Puis, IBM, société pionnière dans l’informatique moderne que vous connaissez tous, mettait l’humain à genou dans les années 90, avec deep blue qui battait Gary Kasparov aux échecs après une deuxième manche. Ce fut un match très suivi, et là encore annonciateur d’une nouvelle ère où la technologie allait bientôt surpasser l’Humain.

C’était une autre époque, il y a 20 ans. On imaginait une société harmonieuse, utopiste, guidée par un incroyable déferlement d’innovations technologiques à venir. Pensez-vous que le rêve s’est réalisé ? Avez-vous vu aujourd’hui autour de vous des machines super intelligentes réaliser l’équivalent de ce que peux faire un humain ? Non, de toute évidence nous n’y sommes pas encore, mais un chemin se trace :

Laissez-moi vous présenter ce qu’il manque aujourd’hui pour réaliser cette fameuse singularité technologique :

La singularité

La singularité technologique promise par le chercheur et futuriste Ray Kurzweil, qui travaille chez Google, c’est le moment où l’intelligence artificielle sera à un point de maturité telle qu’elle bouleverserait nos sociétés. Cette singularité créerait alors une accélération auto-entretenu de l’innovation, voire l’émergence d’une entité autonome capable de s’organiser et de se maintenir en existence. Accessoirement de réduire l’humanité en esclavage.

Alors qu’avons-nous réalisé ces dernières années ? Vous entendez sûrement beaucoup parler d’intelligence artificielle dans les médias généralistes mais la technologie qui est derrière ce mouvement de hype c’est le Deep Learning ou apprentissage profond. C’est précisément ce qui suscite un enthousiasme aussi démesuré aujourd’hui.

Le Deep Learning, c’est la combinaison réussie de plusieurs facteurs :

- Des innovations technologiques de plus en plus importantes qui se traduisent par plus de mémoire, plus de puissance (on utilise principalement des cartes graphiques, les mêmes que vous utilisez pour un jeu vidéo)

- De la donnée en plus grande quantité, stockée et disponible et souvent gratuite

- Des algorithmes qui ne sont certes pas forcément nouveaux mais sur lesquels il y a eu un effort de recherche important ces dernières années. Effort qui est aujourd’hui principalement entretenu par les géants californiens et chinois

Je lis souvent que le Deep Learning, c’est l’intelligence artificielle, et je pense que c’est un raccourci rapide, laissez-moi vous expliquer pourquoi :

Les trois grands visages du Deep learning

Le Deep Learning est en voie d’avoir résolu plusieurs problèmes historiquement complexes, et ça on en peut pas le nier. Ces trois problèmes sont liés à l’image, au son et à la sémantique

Le problème de la vision, c’est la capacité à reconnaître dans une image (qui n’est qu’un ensemble de pixels), des formes, des caractéristiques, et donc in fine à donner un sens à cette image. Vous donnez à l’algorithme par exemple des milliers de photos de chiens et de chats en lui indiquant lesquelles sont de chats et lesquelles de chiens. Et l’algorithme “apprend” ce qui fait qu’une image est “profondément” celle d’un chat ou celle d’un chien. Ainsi lorsqu’il est confronté à une nouvelle image jamais vue, il saura dire de quelle animal il s’agit. Et cet exemple, vous pouvez le décliner sur un grand nombre de cas possibles. En ce sens, l’algorithme réalise une opération similaire à celle du cortex visuel du cerveau humain, sauf que notre cerveau est robuste aux invariances, aux distances, au images incomplètes, à un grand nombre de situations difficiles pour un algorithme. Mais il faut noter que s’il a été entraîné uniquement sur des chiens et des chats, il n’ira pas extrapoler la différence visuelle entre des fraises et des bananes. Son champs d’application reste restreint par son apprentissage initial. L’algorithme est spécifique et c’est sa plus grande faiblesse. On s’approche aujourd’hui de plus en plus des capacités humaines, par exemple sur la reconnaissance de visages.

Le deuxième grand problème partiellement résolu est celui du son, ou plus spécifiquement de la voix.

C’est la capacité à transformer la parole en du texte et inversement, à générer de la voix à partir de texte. Là encore, il faut avouer que c’est assez surprenant car le degré de fiabilité atteint est assez important avec des taux d’erreurs en dessous des 5% pour l’état de l’art de cette année. Et on commence à talonner la performance humaine dans des cas pas trop compliqués. Typiquement lorsque la prononciation est intelligible ou que l’accent n’est pas spécial.

Et puis il y a ce troisième grand problème attaqué de front car porteur de beaucoup de promesses.

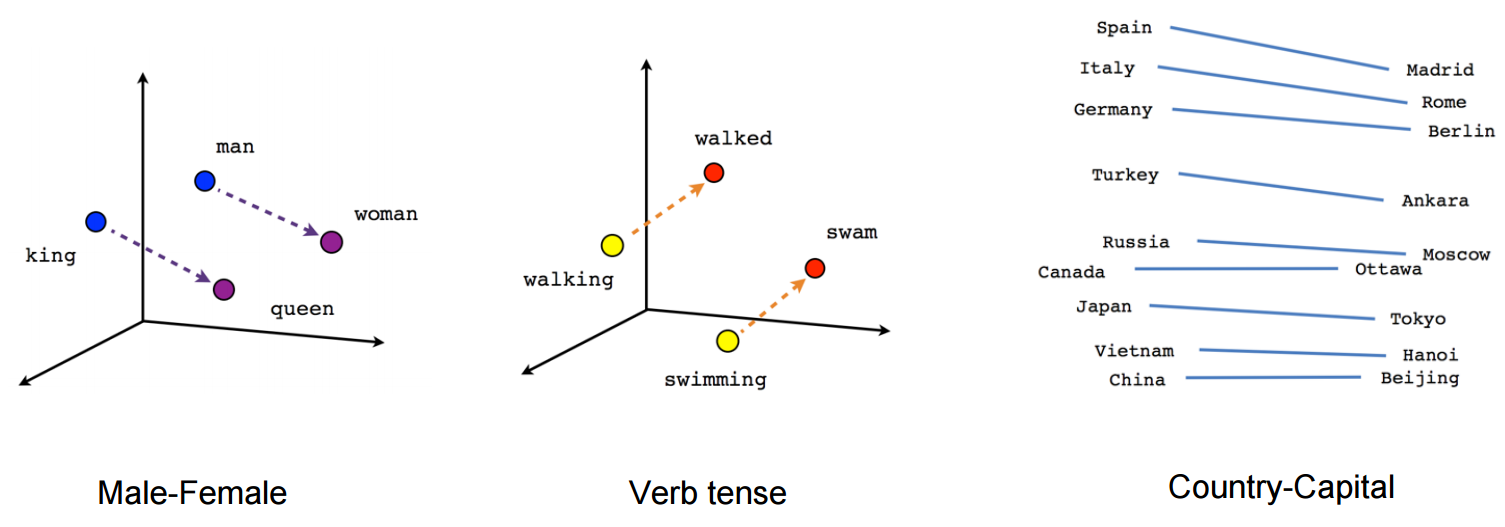

A savoir le problème de la sémantique, du sens des mots. On parle de la capacité d’un algorithme à comprendre les mots. Alors comprendre c’est un bien grand mot, mais disons que l’algorithme de Deep Learning va pouvoir faire des rapprochements entre mots en fonction de plusieurs critères comme la grammaire ou le fait qu’on trouve souvent ces mots ensemble. C’est le champs du Natural Language Processing ou traitement du langage naturel.

Du coup, on peut traduire de manière automatique des langues, c’est ce que fait google avec ce genre de technologies. Il va vous proposer des synonymes en fonction du contexte de votre phrase ou vous corriger des problèmes de grammaire ou de tournure de phrase.

C’est notamment ce qui est utilisé par IBM Watson pour battre l’humain au jeu Jeopardy où il faut en quelque sorte deviner des réponses à des questions généralistes.

A travers ces trois grandes familles de uses cases, on s’est quelque part attaqué aux trois plus importantes interfaces de l’homme avec son environnement. Ce qu’il voit, ce qu’il entend et ce qu’il comprend.

Mais ce ne sont pas les seules initiatives qui vont dans le sens de l’intelligence artificielle forte.

Au-delà du Deep Learning

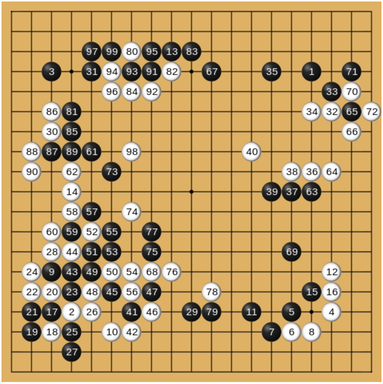

D’autres initiatives supportées par des géants comme Google essaient d’attaquer le sujet de l’intelligence artificielle par des tâches généralistes. On a eu les échecs il y a 20 ans, aujourd’hui on a le jeu du GO (qui est d’ailleurs beaucoup plus compliqué). Mais aussi des tâches comme les jeux vidéos (DOTA ou StarCraft) et ce à travers un domaine qui s’appelle le reinforcement learning ou apprentissage par renforcement.

La promesse de l’apprentissage par renforcement est de donner à un algorithme des situations plus complexes sans le guider directement. On le laisse trouver la meilleure façon d’explorer sa tâche et le contexte autour. Une analogie intéressante de l’apprentissage par renforcement, c’est l’enfant qui apprend à marcher. On ne lui dit jamais comment faire, il trouve tout seul en tombant et en se relevant.

Mais tout ça, est-ce suffisant ? Personnellement, j’ai l’impression qu’on automatise des tâches compliquées, qu’on simule de manière incomplète peut être certaines parties du cerveau mais où est l’intelligence forte ? Celle qui va définitivement remplacer les humains, pour ne pas dire anéantir l’humanité comme c’est prophétisé par certains penseurs

Où allons-nous ?

Et bien l’intelligence forte, on n’y est pas encore : Nous avons répondu à des problématiques superficielles, à ce qui touche à l’interface entre l’humain et son monde. Nous sommes en quelque sorte passé d’une digitalisation à une sémantisation de notre monde, c’est-à-dire que nous avons trouvé des algorithmes qui permettent de ne plus manipuler de la donnée brute mais de manipuler les concepts qui se cachent derrière cette donnée .

Les algorithmes de reconnaissance visuelle ne manipulent plus seulement des images mais manipulent des visages, des cheveux. Les algorithmes de jeu vidéo manipulent des personnages ou des stratégies. La encore, je pose clairement la question : est-ce suffisant de manipuler des concepts pour parler d’intelligence artificielle forte ?

Ce qui fait notre particularité, nous humains, c’est notre capacité à manipuler un très grand nombre de concepts génériques et de dresser une toile d’araignée de sens qui s’enrichit au fur et à mesure de notre apprentissage de la vie. Mais les différents cas d’usage du Deep Learning restent assez segmentées en fonction d’un ou deux domaines à chaque fois. Nous avons encore du mal à faire des ponts entre ces domaines et à tisser cette fameuse toile sémantique. Il manque encore cette glue qui permettrait de faire tenir toutes ces avancées technologiques ensemble de manière cohérente. Nos algorithmes simulent l’apprentissage et l’anticipation dans le futur. Ils disposent d’une représentation généralement assez basique du monde.

Au delà de ces capacité cognitives, il y a une grande propriété fondamentale d’une intelligence forte qu’on ne comprend toujours pas : c’est la conscience. Certains scientifiques pensent qu’elle émerge naturellement de la complexité issue de la puissance de traitement de données. D’autres scientifiques la lient plutôt à des architectures de cerveau spécifiques, architectures que nous comprenons peu et que nous ne pouvons pas dupliquer. Enfin, d’autres personnes vous diront qu’une machine avec une conscience, un but, une motivation, des émotions n’aurait absolument aucun sens.

Le débat est et restera philosophique tant que nous n’aurons pas connu de nouvelles avancées technologiques pour confirmer ou infirmer ces prédictions.